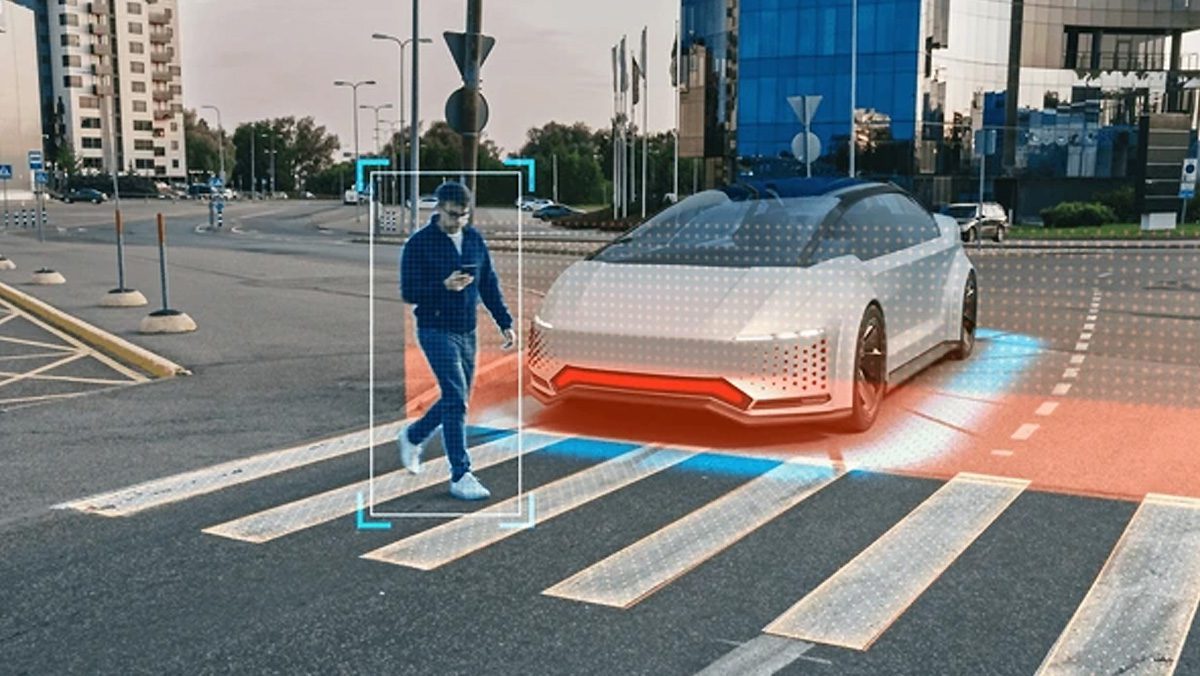

ورود هوش مصنوعی به صنعت خودروسازی، بهویژه در زمینهی خودروهای خودران، چالشهای اخلاقی مهمی ایجاد کرده است. یکی از اساسیترین این چالشها، تصمیمگیری در شرایط اضطراری است؛ جایی که هوش مصنوعی باید بین گزینههای مختلفی که همه میتوانند پیامدهای ناگواری داشته باشند، یکی را انتخاب کند. آیا ماشین باید جان سرنشین را حفظ کند یا عابران پیاده را؟ آیا باید ارزش متفاوتی برای جان افراد قائل شود؟

تصمیمگیری در شرایط اضطراری

یکی از معروفترین مشکلات اخلاقی در خودروهای خودران، مسئلهای است که از معمای کلاسیک «واگن مرگبار» (Trolley Problem) الهام گرفته شده است. طبق این معما سناریویی را در نظر بگیرید که یک خودروی خودران در حال حرکت است و ناگهان دو گزینهی پیش رویش قرار میگیرد:

- اگر مسیر خود را ادامه دهد، به گروهی از عابران برخورد میکند.

- اگر مسیر را تغییر دهد، احتمالاً با یک دیوار برخورد کرده و سرنشین خود را به خطر میاندازد.

کدام انتخاب صحیح است؟ انسانها در این شرایط ممکن است بر اساس احساسات، غریزه یا تصمیم لحظهای واکنش نشان دهند. اما خودروهای خودران با الگوریتمهای هوش مصنوعی تصمیمگیری میکنند که طبق یک برنامهی از پیش تعیینشده عمل میکند. بنابراین، این سؤال مطرح میشود که این تصمیمگیری باید بر چه اساسی انجام شود؟

آیا خودرو باید بیشترین تعداد افراد را نجات دهد، حتی اگر این به قیمت جان سرنشین آن تمام شود؟ آیا خودرو باید همیشه اولویت را به حفظ جان سرنشین خود بدهد، زیرا او مالک و خریدار خودرو است؟ آیا در این تصمیمگیری باید سن، جنسیت یا موقعیت اجتماعی افراد در نظر گرفته شود؟

اولویتبندی جان افراد

یکی از مسائل اخلاقی بحثبرانگیز این است که آیا هوش مصنوعی میتواند بین گروههای مختلف از افراد تبعیض قائل شود؟ برای مثال، در یک تصادف فرضی یک طرف، یک کودک و یک سالمند حضور دارند. در طرف دیگر، یک فرد میانسال و یک پزشک قرار دارند. سؤال این است که آیا باید ارزش جان هرکدام را متفاوت در نظر گرفت؟ آیا یک پزشک که میتواند در آینده جان افراد بیشتری را نجات دهد، باید در اولویت باشد؟ آیا کودک به دلیل سن کم و آیندهی پیش رویش مهمتر است؟

تحقیقات نشان دادهاند که در کشورهای مختلف، نگرشهای متفاوتی دربارهی این موضوع وجود دارد. برای مثال در برخی فرهنگها، نجات جان کودکان در اولویت قرار دارد. در برخی دیگر، حفظ جان بیشترین تعداد ممکن از افراد، ملاک تصمیمگیری است. بنابراین، برنامهریزی الگوریتمهای هوش مصنوعی برای چنین تصمیماتی یک چالش اخلاقی جهانی محسوب میشود.

چه کسی پاسخگو است؟

اگر یک خودروی خودران تصمیم اشتباهی بگیرد و باعث مرگ یا آسیب جدی شود، چه کسی باید مسئول شناخته شود؟ در خودروهای معمولی، راننده تصمیمگیرندهی نهایی است و در صورت بروز تصادف، مسئولیت قانونی و اخلاقی بر عهدهی اوست. اما در خودروهای خودران، کنترل در دست الگوریتمهای هوش مصنوعی است. آیا رانندهی خودرو (حتی اگر هیچ کنترلی روی تصمیمگیری نداشته باشد) همچنان باید مسئول باشد؟ آیا این مسئولیت بر عهدهی سازندگان خودرو و برنامهنویسان هوش مصنوعی است؟ شرکتهایی مانند تسلا، گوگل و مرسدس بنز در حال توسعهی خودروهای خودران هستند. اگر الگوریتم آنها باعث یک تصادف مرگبار شود، آیا باید پاسخگو باشند؟

برخی معتقدند که سازندگان خودرو باید اطمینان حاصل کنند که سیستم هوش مصنوعی به بهترین شکل ممکن طراحی شده است و در صورت بروز خطا، مسئولیت آن را بپذیرند. اما از سوی دیگر، تصادفات همیشه قابل پیشبینی نیستند و ممکن است شرایطی پیش بیاید که هیچ راهحلی بدون آسیب وجود نداشته باشد.

چالشهای اخلاقی در رابطه با حریم خصوصی و نظارت

خودروهای خودران از دوربینها، حسگرها، GPS و ارتباطات اینترنتی استفاده میکنند تا محیط را درک کنند و تصمیمگیری کنند. این سیستمها میتوانند اطلاعات زیادی را دربارهی راننده و مسافران ذخیره کنند، از جمله مسیرهای رفتوآمد و مکانهایی که راننده به آنها سفر کرده است. سبک رانندگی، عادات و حتی موسیقی مورد علاقهی راننده. اطلاعات شخصی مانند چهرهی سرنشینان و زمانهای سفر. سؤال این است که آیا این دادهها باید به شرکتهای خودروسازی ارسال شوند؟ چه کسی به این اطلاعات دسترسی خواهد داشت؟ آیا احتمال سوءاستفاده از این دادهها وجود دارد؟

خطرات نظارت دولتی و دسترسی هکرها

یکی از نگرانیهای دیگر، این است که دولتها یا هکرها میتوانند از این خودروها برای نظارت و کنترل مردم استفاده کنند. اگر دولتها به اطلاعات خودروهای خودران دسترسی داشته باشند، میتوانند رفتوآمد شهروندان را ردیابی کنند. از سوی دیگر، اگر هکرها به سیستم خودرو نفوذ کنند، میتوانند کنترل آن را به دست گرفته و حتی خودرو را به یک سلاح متحرک تبدیل کنند.

آیا خودروهای خودران باید قابل پیشبینی باشند؟

یک بحث دیگر این است که تصمیمگیریهای خودروهای خودران باید قابل پیشبینی باشد یا نه. اگر خودروهای خودران همیشه از یک الگوی ثابت برای تصمیمگیری در شرایط اضطراری استفاده کنند، ممکن است افراد از این الگو سوءاستفاده کنند. برای مثال، اگر مشخص شود که خودروهای خودران همیشه برای نجات عابران پیاده مسیرشان را تغییر میدهند، ممکن است برخی افراد عمداً از این موضوع سوءاستفاده کنند و در خیابانها بایستند تا خودروها متوقف شوند. از این رو، برخی معتقدند که خودروهای خودران نباید بهطور کامل قابل پیشبینی باشند، بلکه باید انعطافپذیری در تصمیمگیری داشته باشند.

با وجود تمام پیشرفتهای فناورانه، هنوز چالشهای اخلاقی بسیاری در زمینهی خودروهای خودران حل نشدهاند. هوش مصنوعی هنوز نمیتواند تصمیمات کاملاً عادلانه بگیرد، زیرا اخلاقیات امری پیچیده و وابسته به فرهنگهای مختلف است.

۲۳ آذر ۱۴۰۴

۲۳ آذر ۱۴۰۴